首页 > 深度 AI 产品经理的必修课:构建自动化评估体系

AI 产品经理的必修课:构建自动化评估体系

AI 产品经理的必修课:构建自动化评估体系

本文来自微信公众号: 骆齐 ,作者:骆齐

你有没有过这种经历:你为了修复Case A,调整了一句Prompt,结果Case A修好了,原本完美的Case B、C、D却突然崩了?这种按下葫芦浮起瓢的“打地鼠”游戏,在过去两年的LLM产品研发中,简直是我的噩梦。

在传统软件开发里,改一行代码,有单元测试(Unit Test)兜底;但在AI开发里,很多人还在靠“Vibe Check”——也就是俗称的“凭感觉测”。随便问几个问题,看着挺像回事,就觉得稳了。

今天我想和大家聊点硬核的:如何告别玄学调优,构建一套属于AI产品的自动化评估体系。这不仅是技术问题,更是AI产品经理必须建立的认知护城河。

01为什么“体感测试”会害死人?

做AI产品久了,你会发现大模型有一个极其讨厌的特性:非确定性。

以前做App,你点击按钮A,它必然跳转页面B。但在LLM里,你输入同样的Prompt,早上的回答和晚上的回答可能就不一样。

更可怕的是,Prompt是一个高度耦合的混沌系统。你为了让它在“写周报”场景下更严肃一点,加了一句指令,结果它在“写情书”场景下也变得像个教导主任。

靠人工测试是测不过来的。

我曾经带过一个客服机器人项目,初期我们靠三个实习生每天肉眼看Log。后来随着Prompt版本迭代,回归测试的工作量呈指数级上升。实习生累到离职,而由于每个人对“好回答”的定义不同(主观性太强),导致我们的模型效果在几个版本间反复横跳。

那时我意识到:没有量化,就没有优化。如果无法用数字衡量你的Prompt改动是“变好”还是“变坏”,那你就是在盲人摸象。

02从0到1:搭建你的评估体系

很多人一听到评估,觉得那是算法工程师的事。大错特错。

定义什么是“好结果”,是产品经理的核心天职。算法关注的是Loss值的下降,而PM关注的是用户体验的交付。

构建一个最基础的自动化Eval体系,其实只需要三步。

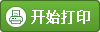

第一步:构建“黄金数据集”

这是所有评估的基石。很多团队做不好评估,是因为手里根本没有“真题集”。

不需要上来就搞几万条数据,那是大厂基建组的事。作为业务PM,你只需要准备50-100条最具代表性的Case。

这些Case应该包含:

高频场景:用户最常问的20%的问题。

长尾/困难场景:以前经常出错的、这就逻辑复杂的坑。

对抗样本:用户故意挑衅、涉黄涉政的钓鱼问题。

关键在于标准答案的制定。

对于提取类任务(比如从简历里提取电话号码),标准答案是唯一的。

对于生成类任务(比如写一首诗),标准答案可能是一个“参考范文”,或者是一组“必须包含的要点”。

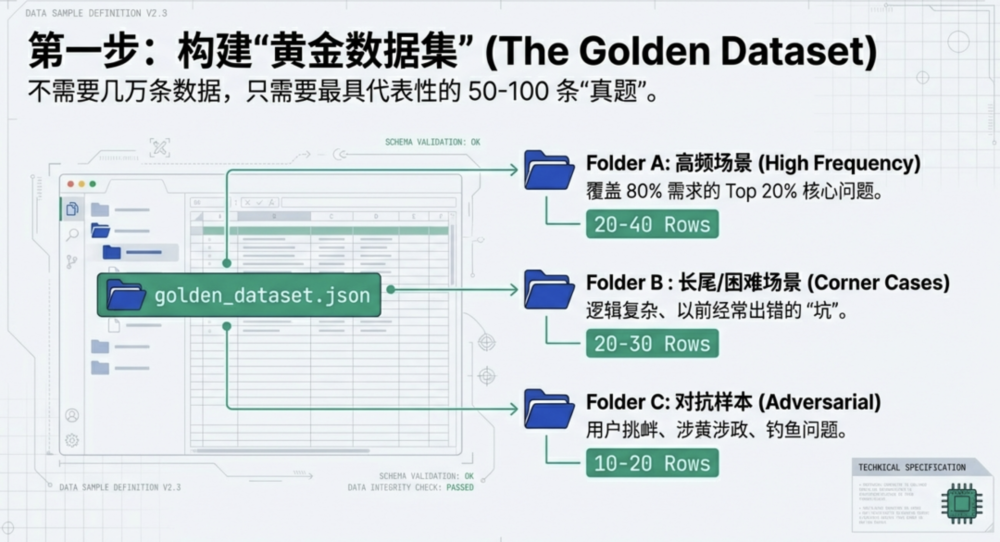

有了题,怎么打分?这里分为两类指标:

这部分好做,写代码正则匹配就行。

格式合规率:要求输出JSON,它有没有输出Markdown?

拒识率:遇到敏感词,是否触发了兜底话术?

包含率:比如要求必须包含“由于系统维护”这几个字,它漏没漏?

这部分是AI PM最头疼的。回答“准确吗?”、语气“友好吗?”、逻辑“通顺吗?”

以前这些只能靠人看,但现在,我们有了魔法:LLM-as-a-Judge(用大模型当裁判)。

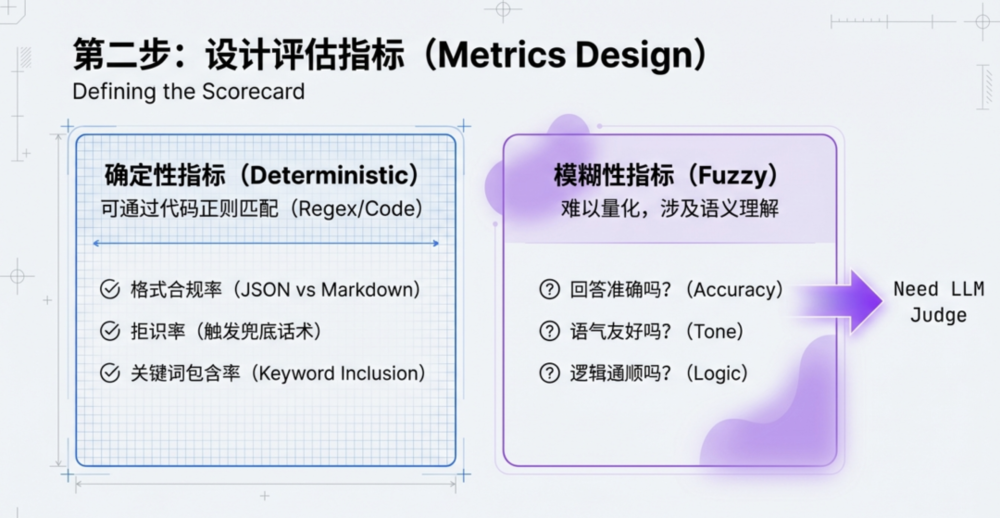

第三步:引入LLM-as-a-Judge

这是目前硅谷最主流的实战流派。既然人看太慢,为什么不让GPT-5来帮我们看?

简单来说,就是写一段专门的Prompt,告诉GPT-5:“你是一个严格的考官,请根据【问题】、【模型回答】和【参考答案】,给【模型回答】打分(1-5分),并给出理由。”

很多人质疑:用AI测AI,这不是套娃吗?准吗?

根据我的实测,在复杂的语义理解场景下,GPT-5作为裁判的判决结果,与人类专家的一致性通常能达到80%-90%以上。

更重要的是,它快,而且不知疲倦。

你可以配置这样的自动化流:

修改了业务Prompt。

脚本自动跑一遍那100条黄金数据集。

GPT-5裁判自动打分。

03进阶:PM如何在评估中发挥价值?

搭建了系统(通常可以使用LangSmith,Promptfoo等工具,或者让研发写个简单的Python脚本),PM的工作才刚刚开始。

1.维护“裁判的价值观”

LLM-as-a-Judge最难的地方在于,你需要把脑子里的“好标准”显性化。

如果你发现裁判打分和你心里想的不一样,通常不是裁判傻,而是你没把标准定义清楚。

你需要不断调试Judge Prompt,比如明确告诉它:“只要没有提到退货政策,无论语气多好,都只能给1分。”

这个过程,本质上是在通过prompt将业务规则代码化。

2.关注Bad Case的这一公里

自动化评分不是为了看一个总分自嗨的。评估跑完后,生成的“错题本”才是金矿。

PM每天的工作重点,应该从“想新功能”,转移到“分析错题”上来。

是Prompt指令不清晰?

是RAG检索到的上下文(Context)是错的?

还是模型本身的能力天花板?

针对每一类错误,制定针对性的优化策略。这才是AI产品迭代的闭环。

在AI时代,产品经理的门槛变了吗?

有人说变低了,因为不用画复杂的原型图了,对着聊天框就能设计产品。

我觉得是变高了。因为我们失去了“确定性”这个拐杖。

评估体系让我们敢于重构Prompt,因为我们知道有测试网兜底;让我们敢于尝试更便宜的小模型,因为我们能监控效果的折损率;也让我们面对老板及客户的质疑时,能拿出冷冰冰但有说服力的数据,而不是苍白的“我觉得挺好”。

从今天开始,哪怕先在Excel里整理出20条黄金Case,也是构建你职业护城河的第一步。

在这个狂奔的时代,“慢”,有时候就是“快”。

。

责任编辑:

文章来源:http://www.jingmeijuzi.com/2026/0129/2014.shtml