首页 > 深度 具身智能争论新焦点:它该是多模态的“副业”,还是物理世界的“新安卓”?

具身智能争论新焦点:它该是多模态的“副业”,还是物理世界的“新安卓”?

最近圈子里有个讨论挺热:具身智能(就是让机器人有身体的AI),到底算不算一个正经的“基础模型”?

很多人的看法是,它无非就是在现有的语言大模型(比如GPT)或视觉模型上,加个控制身体的“插件”,做个微调罢了。这不就是个高级应用吗?

但有一线创业者不这么想。在最近的MEET2026大会上,自变量机器人CEO王潜扔出了一个挺硬核的观点:具身智能,应该是与语言模型、多模态模型完全平行、独立的另一个基础模型。它的服务对象不是虚拟世界,而是物理世界。

这个定性的争论,听起来很学术,但其实关系到整个行业往哪走、钱往哪投。

为什么非得“另立门户”?

王潜的核心论据在于:物理世界和虚拟世界的“游戏规则”压根不一样。

咱们在电脑里训练模型,数据是干净的、可重复的。同一段代码,跑一万次结果都一样。但物理世界充满“意外”:你用同样的力推一个杯子,它每次停的位置可能都不同。这种无处不在的随机性,是代码世界难以想象的。

更重要的是,语言和图像在描述物理交互时是“钝感”的。你怎么用文字或图片精确描述“拧螺丝该用多大力道”?这些涉及力、接触和连续时序的过程,需要一套全新的“描述语言”和模型架构去理解。

所以王潜认为,沿用语言模型的范式来做机器人,是“结构性的错位”。与其修修补补,不如从模型架构、数据、到硬件,为物理世界重做一套“智能底座”。

一个颠覆性的未来推演

如果接受“具身智能是独立基础模型”这个设定,视野会完全不同。

王潜甚至提出了一个大胆的预见:以十年为尺度,具身智能基础模型可能会反过来“吞噬”或“收编”现在如火如荼的多模态模型。

为什么?因为物理世界的学习方式更高级。人类认识一只狗,不是看一万张狗的照片(那是现在的AI做法),而是绕着它看,摸摸它,和它互动。这种带有时序、空间和因果关系的“主动感知”,信息密度和效率高得多。

当为物理世界设计的模型掌握了这种更本质的学习能力,回过头来处理纯图像和语言任务,可能就像降维打击。

我们的观察:争论背后是路线的分岔口

这场争论,本质上是对未来AI主导权的预判。

-

一条路是“虚拟主导”:认为AI的奇点将在代码和数据中诞生,智能先征服虚拟世界,再通过“应用”接管物理世界。机器人只是执行终端。

-

另一条路是“物理优先”:认为真正的通用智能(AGI)必须诞生于并与物理世界互动中。因为一切终极资源(算力、电力、数据)都来自物理世界。无法在物理世界中自主获取和制造资源的AI,是有天花板的。

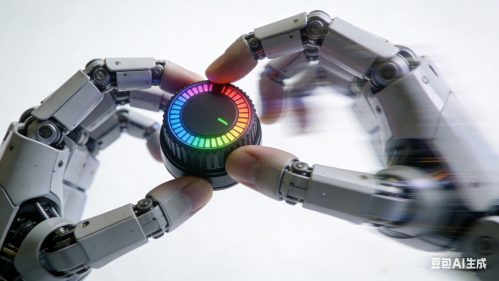

王潜显然是后者。他们的实践,如研发端到端模型驱动高自由度灵巧手、探索“机器制造机器”的自动化生产,都是在尝试打通“感知-决策-行动-制造”的完整闭环。

这不仅仅是技术问题。 它意味着,如果“物理优先”的路线成立,那么整个AI产业的焦点、投资的方向,甚至巨头们的布局,都可能在未来某个时刻发生一次剧烈的转向。

通过端到端模型直接控制的灵巧手,是“物理世界基础模型”的一种实践。

具身智能是否是一个独立的基础模型?这或许不是一场马上能有结论的辩论。

但它像一面镜子,照出了AI发展中的深层焦虑与野心:我们究竟是在为虚拟世界创造一个强大的影子,还是在为物理世界唤醒一个全新的原生智能?

这场争论,值得我们持续关注。

责任编辑:鲸媒

文章来源:http://www.jingmeijuzi.com/2025/1222/603.shtml